INTRODUCCIÓN

Desde que se propone la utilización de una prueba o estrategia diagnóstica hasta que se incorpora finalmente a la práctica clínica debiera existir un proceso sistemático de evaluación. El marco conceptual para la evaluación de pruebas diagnósticas ha ido evolucionando a lo largo de los años. Ha pasado de considerarse un proceso secuencial en fases1, mimetizando en mayor o menor medida las fases I a IV del ensayo clínico, a ser una evaluación globalizadora que considera los aspectos técnicos de factibilidad, reproducibilidad, validez e impacto socioeconómico, y el contexto clínico donde se aplicará la prueba2. Este último aspecto es de vital importancia para determinar las dimensiones más adecuadas de evaluación de la prueba o estrategia diagnóstica. El rol reservado para la prueba, bien sea el de reemplazar a una existente, incorporarla como una prueba previa de cribado ¿o triage¿, o bien utilizarla como una prueba añadida a las que ya se realizan, determinará la dimensión de evaluación más relevante, así como el mejor diseño para determinar sus ventajas3,4.

En los últimos tiempos estamos asistiendo a un periodo de profunda reflexión entre la comunidad científica dedicada a la evaluación de pruebas diagnósticas. Por un lado, la reciente publicación de la guía de graduación de la calidad de evidencias sobre pruebas y estrategias diagnósticas (GRADE)5 y, por otro, la inclusión de Revisiones Sistemáticas de validez de pruebas diagnósticas en la Biblioteca de la Colaboración Cochrane6 son dos hitos dignos de destacar.

En el presente artículo expondremos las características de las revisiones sistemáticas y metanálisis de estudios de validez de una prueba diagnóstica. Asumiendo que el lector está más familiarizado con las revisiones sistemáticas de intervenciones terapéuticas, durante los siguientes apartados ocasionalmente trazaremos el paralelismo entre ambos tipos de revisión para enfatizar las peculiaridades de las revisiones de diagnóstico.

REVISIÓN SISTEMÁTICA

El proceso de la revisión sistemática sigue las habituales fases que se inician con el planteamiento del objetivo de la revisión, la búsqueda bibliográfica y selección de artículos a incluir en la revisión, la evaluación de sus características y su calidad metodológica y el posterior análisis estadístico o metanálisis de sus resultados.

En cuanto al objetivo, las revisiones de diagnóstico con frecuencia se limitan a evaluar el rendimiento de una prueba diagnóstica respecto a un patrón de referencia (gold standard) sin abordar una comparación explícita con otras pruebas alternativas. El contexto clínico donde se aplicarán los resultados de la revisión a veces no es explícito, lo que dificultará su aplicabilidad. Es relativamente fácil utilizar los resultados de una revisión de tratamiento para la toma de decisiones para un paciente en concreto, mientras que en el caso del diagnóstico, esto es más complejo. Por ello, con frecuencia las evidencias arrojadas por la revisión sistemática se utilizan para la toma de decisiones a nivel de gestores y decisores con un punto de vista más cercano a la evaluación de tecnologías sanitarias que a la práctica clínica.

Como en las revisiones de tratamiento, otro de los objetivos de la revisión es analizar los factores que afectan al rendimiento diagnóstico de una determinada prueba, como pueden ser factores relacionados con la población estudiada (espectro de la enfermedad, ámbito de estudio, etc.), características de la prueba y con el diseño del estudio.

Búsqueda y selección de artículos

Como en cualquier revisión sistemática, debe realizarse una búsqueda de estudios exhaustiva, objetiva y reproducible de la investigación primaria. Ésta no debe limitarse sólo a las bases de datos electrónicas, sino que debe complementarse con búsquedas manuales en las listas de referencias bibliográficas de los artículos incluidos, en los resúmenes de congresos relevantes, consultas con investigadores, registros de organismos evaluadores de investigación, etc. Además de las bases electrónicas habituales (MEDLINE y EMBASE) existen bases de datos específicas de estudios de diagnóstico, como la base MEDION7 que recoge revisiones publicadas de estudios de diagnóstico y de cribado.

La identificación de artículos de diagnóstico presenta más dificultades que la búsqueda de ensayos clínicos. No existe como tal un término MeSH (Medical Subject Heading) específico que sea comparable al término «randomized controlled trial». El término «sensitivity and specificity» puede ser el más adecuado, pero no en todas las bases de datos está bien indexado. Muchos de los estudios de diagnóstico se realizan alrededor de la propia práctica clínica sin la existencia de un protocolo registrado y/o aprobado por comités éticos de investigación, con lo que se dificulta su seguimiento. No existe una base de datos centralizada de estudios de diagnóstico equivalente a la de ensayos clínicos. Además, hay estudios que presentan resultados de validez diagnóstica de una prueba sin que éste sea su objetivo principal. Todo esto dificulta el proceso de búsqueda y conlleva que no sea recomendable el uso de filtros metodológicos para intentar restringir y focalizar la búsqueda8.

La valoración del sesgo de publicación en los estudios de diagnóstico es mucho más compleja que su equivalente en estudios de tratamiento. Los funnel plot y demás métodos utilizados para evaluar dicho sesgo de publicación en las revisiones de tratamiento son discutidos para los estudios de diagnóstico9,10. Por otro lado, dado que habitualmente los estudios de diagnóstico no comparan pruebas diagnósticas entre sí, la publicación no suele estar condicionada por la presencia o no de una significación estadística asociada a dicha comparación.

En cualquier caso, como en las revisiones sistemáticas homólogas de tratamiento, el flujo de los estudios desde la búsqueda inicial hasta la realización del metanálisis debería representarse siguiendo la recomendación de las guías QUOROM11, es decir, mediante una gráfica donde consten los distintos estadios con sus exclusiones descritas de acuerdo a las causas.

Evaluación de la calidad de los estudios

Un aspecto clave en toda revisión sistemática es la evaluación de la calidad metodológica de los estudios incluidos con la finalidad de identificar posibles fuentes de sesgos. Vinculado al análisis de la calidad metodológica con que se diseñó y realizó el estudio, se encuentra el análisis de la forma en que se comunican los resultados del estudio. Es difícil distinguir entre ambos aspectos de la calidad dado que ambos están íntimamente relacionados. Para uno y otro análisis existen dos herramientas muy populares en la actualidad. Por una parte, la iniciativa STARD para la publicación de estudios de validez diagnóstica está dirigida a editores de revistas y a los autores de artículos y pretende mejorar la calidad de las publicaciones para permitir así a los lectores evaluar los potenciales sesgos del estudio y juzgar sobre su generalización12,13. Esta iniciativa es al área de investigación sobre diagnóstico lo que el CONSORT fue a la investigación en tratamiento14. Por otra parte, se encuentra el cuestionario QUADAS, ideado específicamente para la evaluación de la calidad de los estudios primarios incluidos en revisiones sistemáticas de diagnóstico15-17. El cuestionario contiene una serie de ítems relacionados con aspectos del diseño y el análisis del estudio que cubren desde el espectro de pacientes incluido hasta la presencia de los sesgos más frecuentes.

El uso que se puede dar a los resultados de este análisis de calidad es un tema de debate. Se propone desde una simple descripción de esta calidad con el objeto de valorar el alcance de las evidencias disponibles, hasta la propuesta más drástica de excluir del análisis a los estudios de más baja calidad. En lo que sí parece haber un cierto consenso es en desaconsejar resumir la calidad en una única puntuación numérica y en la dificultad de incorporar explícitamente la calidad en la ponderación de los estudios primarios a la hora de analizar los datos18. Una alternativa común es la realización de análisis de sensibilidad comparando los resultados que se obtienen incluyendo y excluyendo determinados estudios en función de su calidad o de determinadas características del diseño.

A partir de las publicaciones de Lijmer19 inicialmente, y Rutjes20 más tarde, existe un consenso generalizado en recomendar la exclusión de los estudios con diseño de casos y controles, dado que sobrestiman la validez de las pruebas y pueden considerarse fases previas de la evaluación de la validez1.

Análisis estadístico

En general, el metanálisis es un proceso en dos etapas21. En un primer paso se estiman los resultados de cada estudio, aunque en el caso de la evaluación de pruebas diagnósticas cada estudio es resumido no por un índice, como en los estudios de evaluación de tratamientos, sino por una pareja de índices que describen la validez de la prueba. Habitualmente, estos dos índices son sensibilidad y especificidad, o bien los cocientes de probabilidad positivo y negativo22. Debe huirse, en la medida de lo posible, de utilizar los valores predictivos pues, como es bien sabido, dependen de la prevalencia de la condición clínica que se diagnostica y ésta puede ser muy variable de estudio a estudio. Sin embargo, a veces es el único índice que se puede obtener por las características del método de referencia23. En un segundo paso se deben calcular índices globales de validez para lo que se han propuesto diversos métodos, que se expondrán más adelante.

Abordar un metanálisis sólo es apropiado en el caso de que exista homogeneidad metodológica en los estudios incluidos en la revisión, es decir, que todos ellos hayan evaluado la misma prueba diagnóstica, usando un mismo método de referencia y en pacientes similares. Para valorar estos aspectos se deben extraer los datos pertinentes de los estudios, utilizando formularios ad hoc y en la medida de lo posible por duplicado, para incrementar el grado de objetividad del proceso. Estos datos se referirán a las características del diseño del estudio, su calidad metodológica, las características de los pacientes y del ámbito del estudio, de la prueba evaluada y de referencia y, finalmente, los resultados observados. Es importante destacar que este último aspecto a veces limita la inclusión de un estudio en el análisis. Si no fuera posible extraer los datos de validez diagnóstica de un estudio individual en forma de tabla de clasificación cruzada, el estudio debe ser excluido de la revisión.

Evaluación de la heterogeneidad

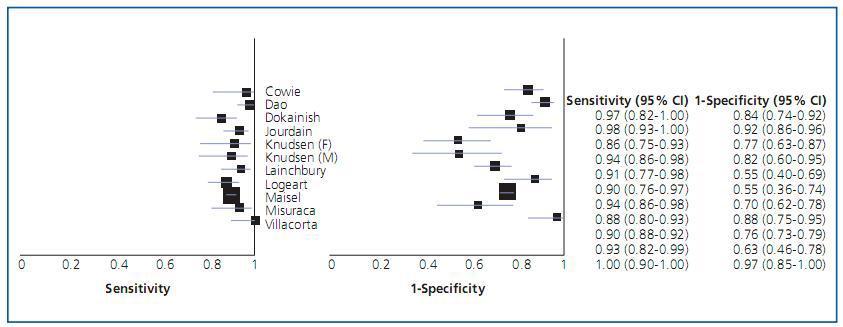

Además de la homogeneidad metodológica mencionada, se debe valorar la eventual presencia de heterogeneidad estadística en los resultados. Esta evaluación puede hacerse gráficamente presentando la sensibilidad y especificidad de cada estudio en un forest plot (figura 1). En estos gráficos se representan los estimadores de los índices junto con sus intervalos de confianza, y suelen presentarse pareados y ordenados de acuerdo a uno de los índices. Lo habitual es encontrar cierta dispersión por el azar en la selección de las muestras de los estudios, pero otros factores la pueden aumentar y el metanálisis debe explorar e identificar estas posibles fuentes de heterogeneidad. Una evaluación estadística de la «cantidad» de heterogeneidad presente se puede realizar mediante una prueba de la ji al cuadrado. Es frecuente cuantificar su magnitud mediante el índice de inconsistencia (I2) y una guía, no exenta de críticas, para su interpretación clasifica el índice en baja (25-50%), media (51-75%) y sustancial (>75%)24.

Una fuente característica de heterogeneidad en los metanálisis de validez de las pruebas diagnósticas es la que surge porque los estudios incluidos pueden haber usado diferentes umbrales para definir qué es un resultado positivo de la prueba. Este efecto es conocido como «efecto umbral». La definición del umbral de positividad a veces puede ser explícita, como en el caso de la proteína C reactiva, o implícita como en el caso de pruebas con interpretación subjetiva (pruebas de imagen) o cuando los resultados de la prueba puedan verse afectados por la calibración del aparato de medida. Desafortunadamente, este efecto está presente con mucha frecuencia en la evaluación de pruebas diagnósticas.

Efecto umbral

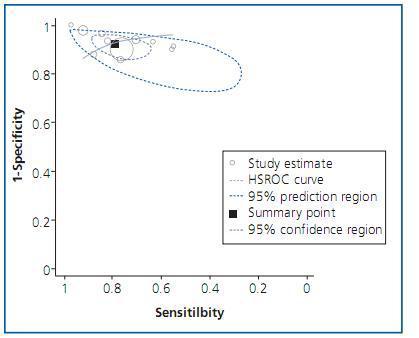

Para explorar esta fuente de variación es útil representar en una gráfica las parejas de sensibilidad y especificidad de cada estudio en un plano ROC (figura 2). En este plano, la zona más cercana a la esquina superior izquierda supone un buen rendimiento diagnóstico mientras que la zona central, la diagonal en la que sensibilidad y especificidad son iguales, representa una nula capacidad diagnóstica. Si existiera «efecto umbral», los puntos en el plano mostrarían un patrón curvilíneo. Cambiando el umbral de positividad de una prueba se obtendría una mayor (o menor) sensibilidad con el consiguiente efecto contrario sobre la especificidad. Además de gráficamente, este «efecto umbral» puede evaluarse mediante el coeficiente de correlación de Spearman entre la sensibilidad y la especificidad, ya que de existir dicho efecto mostraría una correlación inversa25.

Los métodos estadísticos más robustos propuestos para el metanálisis tienen en cuenta esta correlación entre sensibilidad y especificidad, y lo hacen mediante la estimación de una curva ROC resumen (sROC) de los estudios incluidos. En presencia de «efecto umbral», no es adecuado aglomerar los índices de sensibilidad y especificidad (o cocientes de probabilidad) independientemente uno del otro ignorando su correlación.

Sin embargo, en limitadas ocasiones los resultados de los estudios primarios son homogéneos y puede descartarse la presencia tanto de efecto umbral como de otras fuentes de heterogeneidad. En esta situación, el resultado global de la revisión podría obtenerse a partir de la combinación ponderada de los índices de los estudios individuales. Como siempre, esta combinación puede hacerse mediante un modelo de efectos fijos o bien mediante un modelo de efectos aleatorios, dependiendo de la magnitud de la heterogeneidad.

Se han propuesto varios métodos para estimar la curva sROC. El primero de ellos, debido a Moses, et al.26, se basa en estimar la regresión lineal entre dos variables creadas a partir de los índices de validez de cada estudio. Estas variables son D y S, que representan, respectivamente, el logaritmo del odds ratio diagnóstico (ORD)27 y una medida indirecta del umbral de positividad de la prueba calculada como:

S = logit(TVP) + logit(TFP).

TVP y TFP son las tasas de verdaderos y falsos positivos, respectivamente, y logit(TVP) es el logaritmo de TVP dividido por su complementario (1¿TVP). Es fácil ver que ambas tasas de resultados positivos cambian con el umbral de positividad de la prueba.

La propuesta de Moses consiste en ajustar el modelo D = a + bS. El contraste sobre si hay variación del rendimiento diagnóstico (medido por el ORD) con el umbral es equivalente al realizado sobre el parámetro b del modelo. Si b = 0 no hay variación y el método da lugar a una curva sROC simétrica mientras que si b ≠ 0 existe variación del rendimiento con el umbral y la curva sROC es asimétrica y se obtiene deshaciendo la transformación a los ejes originales del plano ROC.

El modelo puede extenderse para analizar el efecto de otros factores sobre el rendimiento diagnóstico (ORD). Estos factores pueden ser relativos al diseño del estudio, características de los pacientes o del test y se incluirían en el modelo anterior como covariables28.

Se han propuesto distintos estadísticos útiles para resumir una curva sROC. El más habitual es el área bajo la curva (ABC) que resume el rendimiento diagnóstico de la prueba en un solo número29: las pruebas perfectas tienen un ABC cercano a 1 y las inútiles cercano a 0,5. Este número puede interpretarse como la probabilidad de clasificar correctamente a dos sujetos seleccionados al azar, uno con la enfermedad y otro sin ella. Finalmente, puede usarse el área para comparar el rendimiento de distintas pruebas diagnósticas. Otro estadístico útil es el índice Q*, definido como el punto en el que la sensibilidad y la especificidad son iguales. En una curva simétrica este punto es el más cercano al extremo superior izquierdo del plano ROC. Por último, la curva sROC ajustada puede utilizarse para extrapolar una sensibilidad a partir de una especificidad dada o viceversa.

Modelos bivariantes y jerárquicos

El modelo de Moses presenta algunas limitaciones. Por una parte, no tiene en cuenta la distinta precisión con la que se estimaron la sensibilidad y la especificidad en cada estudio, tampoco incorpora la heterogeneidad entre estudios y, por último, la variable independiente del modelo es aleatoria y, por tanto, tiene error de medición30. Para superar estas limitaciones, se han propuesto recientemente modelos de regresión más complejos para estimar la curva sROC.

El primero de ellos es un modelo de efectos aleatorios, bivariante, que parte de la asunción de que los logit de sensibilidad y especificidad siguen una distribución normal bivariante. El modelo contempla la eventual correlación entre ambos índices, modeliza la distinta precisión con la que han sido estimadas la sensibilidad y la especificidad e incorpora una fuente de heterogeneidad adicional debida a la varianza entre estudios31.

La segunda propuesta se refiere al modelo conocido como HSROC o modelo jerárquico. Es similar al modelo anterior, salvo que hace explícita la relación existente entre sensibilidad y especificidad a través del umbral. Como el anterior, también tiene en cuenta la heterogeneidad entre estudios1,32.

Ambos modelos, bivariante y jerárquico, permiten obtener estimaciones promedio de sensibilidad y especificidad con sus correspondientes regiones de confianza y predicción. Las diferencias entre ambos modelos son pequeñas y recientemente se ha demostrado que, en ausencia de covariables, ambos abordajes son distintas parametrizaciones del mismo modelo33. Aunque recientemente se ha abogado por la necesidad de utilizar estos métodos34, los resultados proporcionados por estos métodos más sofisticados son muy similares a los obtenidos por el modelo de Moses35.

Existe una gran variedad de paquetes estadísticos que pueden utilizarse para realizar los análisis descritos. Unos son de propósito general, como el SAS y el Stata, que a través de una serie de macros programadas por usuarios facilitan la obtención de los modelos descritos. Las más populares son las macros de Stata denominadas midas36 y metandi37, y la macro desarrollada para SAS denominada metadas38. Otros programas específicos para el metanálisis de estudios de pruebas diagnósticas son el Meta-DiSc39 y el RevMan40 en su versión 5. Ambos realizan los análisis básicos mencionados en este artículo, si bien RevMan permite incorporar los resultados obtenidos con los modelos bivariantes.

Aunque nos hallamos en una época muy activa en el diseño de métodos para realizar las revisiones sistemáticas de pruebas diagnósticas, queda mucho camino por andar hasta llegar a equiparar estos métodos con los desarrollados en el ámbito de las revisiones de tratamiento. Estamos seguros de que en un futuro cercano irán apareciendo más desarrollos metodológicos que situarán a la investigación sobre pruebas diagnósticas en el lugar que le corresponde por su importancia en el proceso clínico-asistencial.

Figura 1.

Figura 2.